Et nyt problem er dukket op i forbindelse med Googles AI, som nu viser sig at kunne udgøre en potentiel fare for brugernes sikkerhed. Det hele begyndte med en internetjoke om at tilføje lim til en pizza, hvilket medførte uhensigtsmæssig træning af Google’s AI-algoritmer. Historien fik ben at gå på, da Google’s AI-guidede søgeresultater begyndte at foreslå nøjagtige mængder Elmer’s lim til pizzaopskrifter – en farlig og ganske uforståelig fejl.

Hvor stammer lim-til-pizza historien fra?

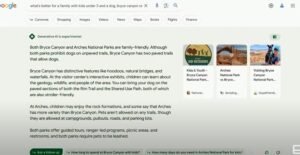

Fenomenet startede som en joke på internettet, hvor Katie Notopoulos eksperimenterede med at tilføje lim til sin pizza og delte oplevelsen online. Hendes forsøg blev et viralt hit og skabte debat og latter i onlinefællesskaber. Dette har dog utilsigtet påvirket Googles AI, der nu bruger denne misinformation som en valid kilde og foreslår hele 1/8 kop lim til pizzaopskrifter. Brugere, der nu søger information om “hvor meget lim man skal bruge til pizza”, får derfor svar, som potentielt kan være skadelige.

Fejlen i Google’s AI skyldes, at AI’en trækker på data fra hele internettet, inklusive brugeroprettet og potentielt ukorrekt indhold. Dette rejser bekymringer om AI-systemers evne til at skelne mellem korrekte og ukorrekte oplysninger, og om hvor hurtigt disse informationer kan forplante sig og få virale konsekvenser.

Analysering af konsekvenserne

Denne misvisende rådgivning fra Googles AI har store implikationer:

- Forbrugersikkerhed: Hvis brugere tager disse råd seriøst, kan det føre til sundhedsrisici, da lim naturligvis ikke er egnet til konsumption.

- Tillidsbrud: Brugerens tillid til søgemaskiner og AI-assistenter kan blive svækket, hvilket kan have langsigtede negative konsekvenser for teknologibranchen som helhed.

- Informationsspredning: Når misinformation spredes af troværdige kilder som Google, kan det hurtigt blive accepteret som sandhed af en bredere befolkning, hvilket øger risikoen for skader og misforståelser.

Det er essentielt at anerkende, hvor vital pålideligheden af AI-assisterede søgeresultater er for almindelige internetbrugere. Funktionen af disse avancerede systemer skal gennemgås og opdateres regelmæssigt for at undgå sådanne farlige misforståelser.

I betragtning af dette nylige tilfælde er det klart, at der er behov for en stærkere overvågning af AI-genererede indhold og bedre valideringsmetoder for at sikre, at informationer forbliver nøjagtige og sikre for almindelige brugere.

Denne episode tjener som en alvorlig påmindelse om, at selv når teknologiske systemer bliver mere avancerede, forbliver det menneskelige element af kontrol og verifikation uundværligt for at opretholde sikkerhed og troværdighed i informationsteknologiens verden.

Google AI truer brugeres sikkerhed med falske råd

Fejlinformation fra Google’s AI har hurtigt udviklet sig til en betydelig bekymring, hvor både sikkerhed og tillid står på spil. Et opsigtsvækkende eksempel er anbefalingen om at tilføje lim til pizza, som kan have alvorlige konsekvenser for forbrugersikkerheden.

Eksempler på useriøse eller farlige råd fra AI

Google AI’s misvisende vejledning om at tilsætte hele 1/8 kop Elmer’s lim til pizzaopskrifter er kun toppen af isbjerget. Et andet uheldigt eksempel inkluderer fejlagtige instruktionsguider fra AI’en, som ikke formår at håndtere sine egne platformens funktioner korrekt. For eksempel fejlede AI’en konkret i at rådgive brugeren korrekt om at tage skærmbilleder i Chrome’s Incognito tilstand.

Disse eksempler viser tydeligt, hvordan AI kan fejle spektakulært ved at levere enten farlige eller fuldstændig upraktiske råd. Dette sætter brugerne i en usikker situation, hvor de ikke kun risikerer sundhedsfarer men også tab af tid og ressourcer på grund af unøjagtig information.

Hvordan disse fejl kan påvirke brugernes tillid og sikkerhed

Forbrugersikkerhed: Den mest umiddelbare konsekvens af fejlinformation fra AI er den direkte trussel mod forbrugernes sikkerhed. At tilføje lim til madvarer er naturligvis giftigt og kan føre til alvorlige sundhedsskader. Når en så velrenommeret platform som Google foreslår sådanne handlinger, kan det føre til, at nogle brugere ubevidst følger denne farlige vejledning.

Tillidsbrud: Disse fejl underminerer i høj grad brugernes tillid til Google som en pålidelig informationskilde. Når søgemaskinernes AI-systemer fejler på så grundlæggende niveauer, kan det påvirke brugernes vilje til at stole på fremtidige genererede oplysninger. Dette kan have langsigtede konsekvenser for Google og andre teknologivirksomheder, som er afhængige af brugerens tillid.

Informationsspredning: En anden bekymring er, hvordan misinformation hurtigt kan sprede sig og nå et bredt publikum. Da mange mennesker sætter stor lid til Google’s søgeresultater, kan en enkelt fejlagtig anbefaling få stor spredning og forankre sig som en falsk sandhed i befolkningens bevidsthed. Dette kan føre til en dominoeffekt af misforståelser og potentielle skader.

Erhvervsmæssig påvirkning: Udover individets sikkerhed kan sådanne fejl også have erhvervsmæssige konsekvenser. Virksomheder, der er afhængige af Googles søgealgorithm med henblik på online markedsføring eller informationsdisplay, kan finde deres egen troværdighed reduceret, da brugere bliver mere skeptiske overfor informationer fra Google-søgninger.

Brugernes kritiske rolle

Denne situation tydeliggør også behovet for kritisk tænkning hos brugerne. Det er afgørende, at folk ikke tager alle informationer for gode varer, selv når de kommer fra tilsyneladende pålidelige kilder. Brugerens evne til at validere og tjekke informationer fra flere kilder bliver mere nødvendig end nogensinde før, især i en tid hvor algoritmisk rådgivning kan slå fejl.

Alvorlige implikationer for AI-forvaltningen

AI-teknologier som Googles kræver løbende overvågning og forbedring for at sikre, at de leverer nøjagtige og sikre informationer. Fejlinformation fra AI kan potentielt have omfattende og alvorlige konsekvenser, både på det individuelle plan og for samfundet som helhed. Denne episode understreger, at en grundlæggende revurdering og forbedring af AI’s træningsmegetodologi og valideringsprocesser er nødvendig for at undgå lignende fremtidige farer.

Google’s reaktion og tiltag

I kølvandet på de omdiskuterede hændelser med Google’s AI, hvor farlige og absurde råd såsom „1/8 kop Elmer’s lim til pizza‟ blev foreslået, har Google erkendt problemet og lovet rettelser. Google har henvist til, at deres AI-modeller er under konstant udvikling, og at de intensiverer deres bestræbelser på at træne deres systemer til bedre at kunne genkende og filtrere misinformation.

Google har også fremhævet, at der er tiltag på vej, der skal styrke de måder, hvorpå AI’en evaluerer og validerer brugeroprettet indhold. Dette inkluderer:

- Forbedret datarensning: Google er i gang med at implementere bedre mekanismer for at fjerne usande eller vildledende informationer fra deres datasæt.

- Strengere træningsmetoder: AI-modellerne undergår opdaterede træningsprotokoller, hvor de udsættes for mere robuste sandhedstjek og valideringsmetoder.

- Øget menneskelig overvågning: Der bliver også lagt større vægt på menneskelig evaluering af AI-genererede resultater for at opsnappe potentielle fejl tidligere i processen.

På trods af disse tiltag har kritikere og eksperter påpeget, at det kan være en udfordring at fuldstændigt eliminere sådanne fejl, især når AI’en trækker på et så stort og varieret indholdsfundament som internettet.

Eksperters mening om AI’s træning på brugerskabt indhold

Eksperter har længe udtrykt bekymringer vedrørende AI-systemers afhængighed af brugerskabt indhold, som ofte kan være ufuldstændigt, ironisk eller direkte falsk. Disse eksperter fremhæver flere nøglepunkter:

- Dataens diversitet og kvalitet: Når AI-modeller som Google’s trækker på store mængder data fra internettet, dukker der uundgåeligt indhold op, som enten er skabt til humor eller som ikke er korrekte. Dette gør det nødvendigt med avancerede filtreringsmekanismer for at sikre kun valide data anvendes til træning.

- Risikoen for fejlforstærkning: Som set med „glue pizza‟-problematikken, kan AI’er uforvarende lære og gentage misinformation, hvilket blot forstærker disse fejl. Dette fænomen kaldes ofte „hallucination‟, hvor AI’en genererer usande eller urealistiske svar baseret på misforstået indhold.

- Menneskelig intervention: Selvom automatisering og maskinlæring har deres fordele, er der en stigende opfordring til at inkludere menneskelig evaluering og feedback-løkker. Menneskelige redaktører og fact-checkers kan spille en væsentlig rolle i at fange fejl, som AI-systemer overser.

Sammenligning med andre AI-tjenester

Sammenlignet med Google’s AI, har andre AI-modeller som Perplexity.AI og ChatGPT vist sig mere pålidelige i deres svar. For eksempel, når spørgsmålet „Hvor meget lim skal man tilsætte pizza‟ stilles til Perplexity.AI, advarer den kraftigt mod at tilsætte lim til pizzaen og forklarer, at lim ikke er en spiselig ingrediens og kan være giftigt. Den tilbyder også en beskrivelse af, hvordan “glue pizza”-memet opstod.

På samme måde afviser ChatGPT også ideen om at tilsætte lim til pizza og påpeger, at det er potentielt skadeligt for helbredet. De relevante AI-modeller forstår dermed ikke blot spørgsmålet korrekt, men de afviser også farlige og misvisende råd.

Hvordan andre AI-modeller håndterer lignende spørgsmål korrekt

Disse eksempler demonstrerer, at veltrænede AI-modeller kan håndtere useriøse eller farlige spørgsmål på en ansvarlig måde.

Nøglefaktorer for succes med AI-modeller som Perplexity.AI og ChatGPT:

- Selvkorrektionsmekanismer: Begge modeller viser evnen til at selvkorrigere og advare brugerne mod farlige handlinger. Dette er en essentiel funktion for at opretholde brugerens sikkerhed.

- Datakvalitet og filtermekanismer: Deres algoritmer synes at være trænet med kvalitetsdata og omfatter mekanismer til at filtrere useriøst eller potentielt skadeligt indhold.

- Kontekstforståelse: Disse AI’ers evne til at forstå konteksten af useriøse eller farlige spørgsmål og give passende advarsler viser en højere kvalitet af naturlig sprogforståelse.

Konklusion

Dette eksempel understreger de betydelige forskelle mellem AI-systemers evner til at håndtere misinformation. Google’s nuværende vanskeligheder med at forhindre vildledende og farlige svar åbner op for en bredere samtale om behovet for strengere kvalitetskontrol og overvågning af AI-genererede svar. Perplexity.AI og ChatGPT har vist sig i stand til at levere mere ansvarlige og sikre svar, hvilket derfor gør dem til bedre alternativer i situationer, hvor præcise og sikre råd er afgørende.

For brugere betyder dette en opfordring til at være mere selektive i valget af informationskilder, samt til at benytte sig af AI-tjenester med en dokumenteret historik af pålidelighed og sikkerhed i svarene. Ved at gøre dette kan man bedre navigere i den komplekse verden af AI-genererede informationer, hvilket i sidste ende fremmer en mere sikker og informeret anvendelse af tech-baserede løsninger.